在当今大数据和机器学习的时代,对于计算机资源的高效管理是至关重要的。而Apache Airflow就是一款强大的开源工作流管理平台,它可以帮助用户轻松实现任务调度和工作流自动化。

什么是Apache Airflow

Apache Airflow是一个通过Python编写的开源工作流自动化和调度工具,它具有任务调度、任务依赖性管理、工作流编排、任务监控、任务错误处理等功能。它的核心理念是将任务和它们的依赖关系用代码进行描述,从而实现可视化地编排和管理任务的自动化。

Apache Airflow的核心概念

任务(Task)

在Airflow中,任务是最小单位,它代表了一个要执行的操作,比如数据处理、模型训练等。每个任务都有一个唯一的标识符和一组参数。任务可以是可重用的,可以通过编写自定义的Operator来定义新的任务。

工作流(Workflow)

工作流是由一系列有依赖关系的任务组成的,可以按照预定义的顺序执行。Airflow中使用DAG(Directed Acyclic Graph)来表示工作流,DAG中的节点代表任务,边代表任务之间的依赖关系。通过定义DAG,可以构建出复杂的工作流。

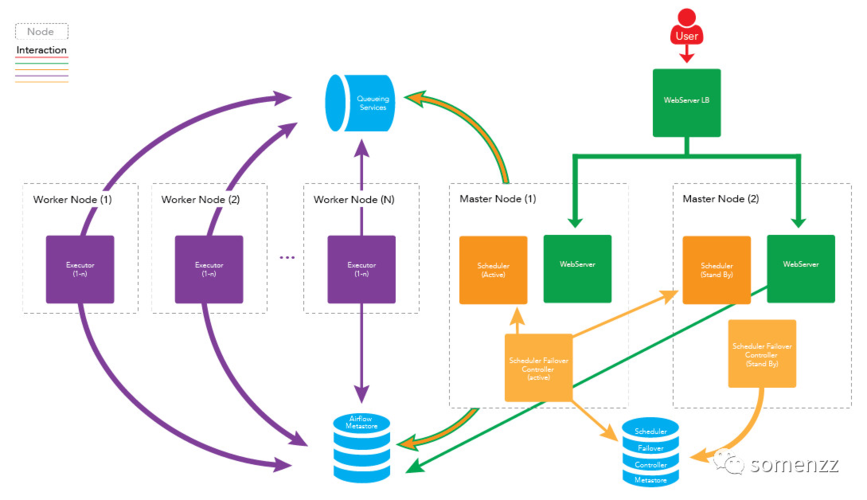

调度器(Scheduler)

调度器是Airflow的核心组件之一,它负责根据预定的调度策略来触发任务的执行。调度器可以根据任务之间的依赖关系,自动计算任务的执行顺序,并将任务分配给可用的执行器进行执行。

执行器(Executor)

执行器是Airflow的另一个核心组件,它负责执行任务。Airflow支持多种类型的执行器,包括本地执行器、分布式执行器等。执行器可以并行执行多个任务,提高整体的执行效率。

监控和日志(Monitoring & Logging)

Airflow提供了丰富的监控和日志功能,可以帮助用户实时监控任务的执行情况并进行错误处理。通过监控和日志,用户可以及时发现和排查任务执行中出现的问题,保证任务的顺利完成。

使用Apache Airflow的好处

使用Apache Airflow可以带来许多好处:

可视化编排和管理

通过Airflow的Web界面,用户可以直观地查看和管理任务和工作流,通过拖拽和连线的方式定义任务的依赖关系,轻松构建复杂的工作流。

灵活可扩展

Airflow使用Python编写,用户可以通过编写自定义的Operator和Hook来扩展Airflow的功能。同时,Airflow支持多种类型的执行器和调度器,用户可以根据需求选择合适的组件。

任务调度和工作流自动化

Airflow可以根据预定的调度策略,自动触发任务的执行,并根据任务之间的依赖关系来计算任务的执行顺序。用户只需要定义好工作流,剩下的工作由Airflow自动完成。

可靠性和容错性

Apache Airflow具有丰富的监控和日志功能,可以帮助用户实时监控任务的执行情况,并进行错误处理。即使任务执行失败,Airflow也可以根据预定义的规则进行重试和错误处理,保证任务的可靠完成。

总结

Apache Airflow提供了强大的工作流管理和任务调度功能,可以帮助用户实现任务调度和工作流自动化。通过Airflow,用户可以可视化地编排和管理任务,提高计算机资源的利用效率,实现高效的数据处理和机器学习工作流。如果你还没有尝试过Airflow,我强烈推荐你开始使用它,相信它会为你的工作带来很大的帮助。