数据流处理是现代数据工程领域的一个关键挑战。Apache NiFi和Kettle(也称为Pentaho Data Integration)是两个备受欢迎的开源工具,用于帮助数据工程师和数据科学家在整个数据流处理过程中实现数据采集、转换和加载(ETL)任务。尽管两者都在相同的领域发挥着重要的作用,但它们具有不同的特点和功能。本文将比较Apache NiFi和Kettle,以便读者更好地理解它们的异同之处,以及在不同场景中的适用性。

架构与特点

Apache NiFi

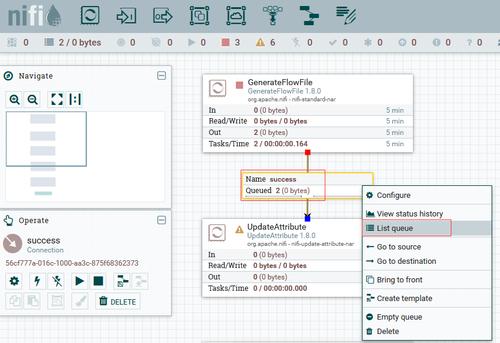

Apache NiFi是一个可扩展、可靠的数据流处理系统,其核心理念是将数据流看作一系列可配置的处理器和连接器。NiFi的架构基于流程图,可通过简单直观的方式描绘整个数据流,并提供了丰富的流程控制和数据流转换功能。Apache NiFi支持大规模分布式处理和可视化数据流监控,具有强大的故障恢复机制。它还提供了各种内置的处理器和连接器,可用于数据源的读取和写入、格式转换、数据加密等任务。

Kettle

Kettle是Pentaho Data Integration的一部分,它是一个强大的ETL工具,用于数据集成、转换和加载。Kettle的架构包括编辑器、调度器和一组经过测试的转换和作业。通过使用Kettle的图形用户界面(GUI),用户可以创建ETL转换,进行数据的抽取、清洗、转换和加载。该工具还支持直接连接到各种数据源,并提供了基于图形界面的ETL设计和开发环境。

功能比较

易用性

Apache NiFi提供了直观的用户界面,使得数据工程师可以轻松创建和管理数据流。它提供了可拖放的处理器和连接器,使得数据转换和流程控制变得简单。Kettle也拥有友好的GUI,但需要一些学习和适应时间,尤其是对于那些刚开始使用ETL工具的用户。

处理能力

Apache NiFi可以在大规模分布式集群中运行,并具有高度可扩展的架构。它可以处理大量的数据流,支持流与流之间的连接、合并和分发,以满足不同的数据处理需求。相比之下,Kettle更适用于小规模和中等规模的数据处理任务。

数据集成

Apache NiFi支持广泛的数据源和数据目的地,可以直接连接到各种数据库、云存储和文件系统。NiFi还提供了丰富的处理器和连接器,用于数据转换、格式转换和数据加密。Kettle也具有类似的功能,但在特定的数据源和数据目的地支持上可能相对较少。

社区支持

Apache NiFi的社区非常活跃,拥有庞大的用户群体和开发者社区,提供广泛的文档、教程和示例。Kettle的社区也相对活跃,但相比之下不及NiFi。这意味着在遇到问题或需要技术支持时,Apache NiFi的用户将更容易找到帮助和资源。

适用场景

Apache NiFi适用于数据量大、数据流复杂的场景,例如大规模数据采集、实时数据处理和数据传输等。它的可扩展性和高度可靠性使得它成为处理海量数据的理想选择。

Kettle更适用于小型和中型的ETL任务,特别是在开发周期紧张的项目中。它具有较低的学习曲线,提供了基于图形界面的ETL设计环境,使得开发和维护ETL作业更加高效。

总结

在数据流处理领域,Apache NiFi和Kettle是两个备受欢迎的开源工具。Apache NiFi提供了直观的界面、高度可扩展的架构和丰富的功能。Kettle则更专注于ETL任务,提供了便捷的图形化开发环境。选择合适的工具取决于项目需求和处理规模,建议根据具体情况来评估和选择。